En 1971, le 4004 d’Intel exécute ses premières instructions sur une puce de 4 bits, marquant une date fondatrice dans l’histoire des microprocesseurs. Cette création précède de peu l’apparition d’autres architectures, parfois oubliées, qui modifieront durablement les trajectoires technologiques.Certains prototypes, jamais commercialisés, ont pourtant posé les bases de principes fondamentaux appliqués encore aujourd’hui. L’émergence de ces premiers processeurs, souvent le fruit de paris techniques audacieux, révèle une succession d’innovations et de compromis décisifs pour l’avenir de l’informatique.

À quoi ressemblait l’informatique avant l’invention du microprocesseur ?

Avant l’arrivée du microprocesseur, l’informatique rimait avec défi quotidien et prouesse technique. Les premiers ordinateurs, tels l’ENIAC ou le Colossus, dans les années 1940 et 1950, étaient des colosses mécaniques. Ils occupaient des pièces entières, engloutissaient une énergie considérable, et chaque changement demandait la main experte de techniciens pour replacer des fils ou remplacer des tubes à vide, sensibles aux pannes et générateurs de chaleur. Programmer relevait parfois d’un casse-tête où la moindre erreur imposait de reconfigurer physiquement la machine, de recommencer de longues séquences, ou de perforer d’interminables cartes.

À cette époque, la rapidité était toute relative. Une simple opération de calcul réclamait plusieurs secondes, chaque cycle d’instructions étant géré par des relais robuste mais lents. L’enchaînement des tâches se devait d’être impeccable et précis, sans quoi un plantage obligeait tout à revoir depuis le début.

La Seconde Guerre mondiale finie, les évolutions reprennent. Le transistor, puis le circuit intégré, poussent la miniaturisation. Malgré ces progrès, jusque dans les années 1960, seuls quelques centres de recherche possèdent de véritables puissances de calcul. Les ordinateurs commencent à offrir un soupçon de multitâche, mais les processeurs, eux, relèvent encore de la science-fiction. Ce sont des monstres bardés de tuyaux et de câbles, où chaque nouvelle machine paramètre une étape supplémentaire vers l’automatisation du calcul.

Le tout premier processeur : une révolution discrète mais décisive

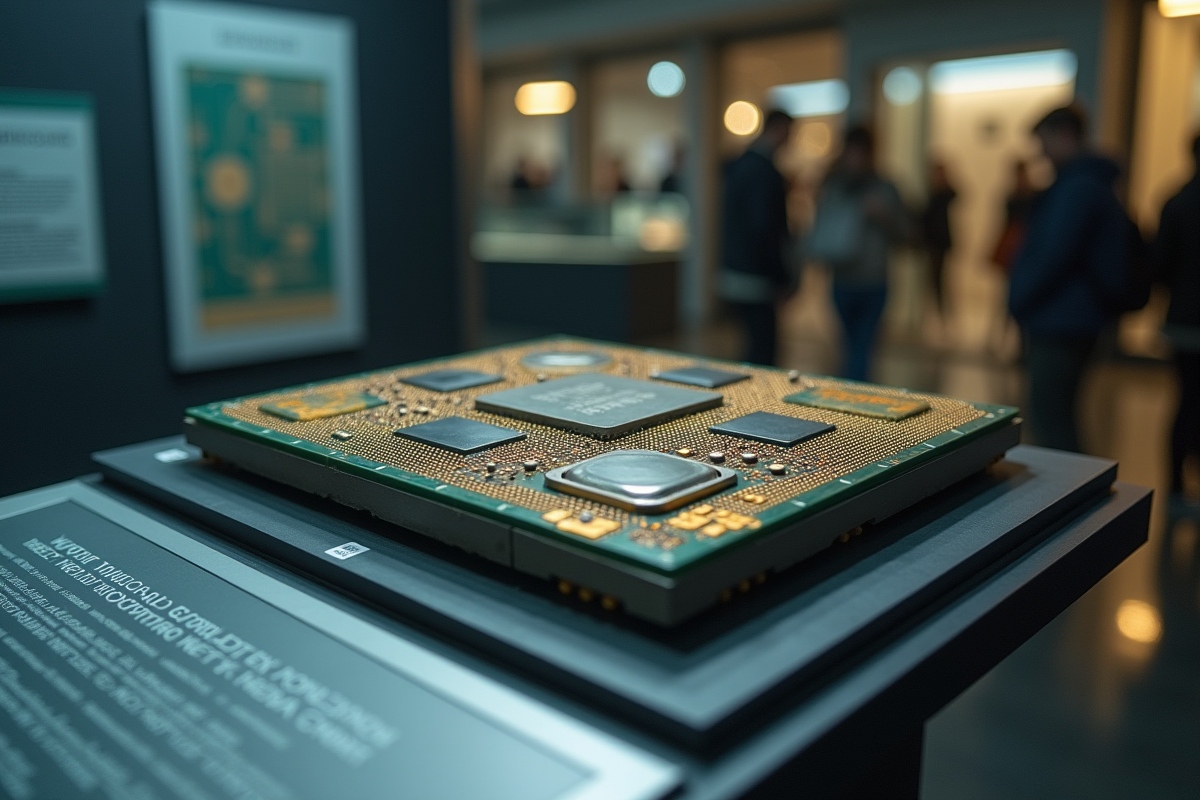

1971. Sur le chantier d’une simple calculatrice, l’histoire bascule. L’Intel 4004, conçu par une équipe de quatre ingénieurs, transforme un projet marginal en un basculement majeur pour l’informatique moderne. Federico Faggin, Ted Hoff, Stanley Mazor et Masatoshi Shima, guidés par Gordon Moore et Robert Noyce, réalisent le premier microprocesseur commercialisable, fruit d’une prise de risque inhabituelle pour l’époque.

Ce composant renferme 2 300 transistors et traite des instructions de 4 bits à une fréquence de 740 kHz. Dit ainsi, cela semble modeste. Pourtant, l’ampleur du changement est bel et bien là : pour la première fois, toute une unité de traitement central tient sur une puce minuscule. Le cœur battant de la calculatrice pouvait, dès lors, trouver sa place dans d’innombrables appareils. Un socle pour d’innombrables innovations à venir.

Plus qu’un exploit technique, l’apparition du 4004 permet à d’autres ingénieurs de repenser la conception des machines. Les ordinateurs rétrécissent, deviennent moins énergivores, plus robustes aussi. L’innovation ne concerne plus seulement la puissance, mais aussi la flexibilité, la portabilité et bientôt, l’accessibilité plus large.

Quelques caractéristiques marquantes de ce processeur pionnier méritent d’être mises en avant :

- 2 300 transistors fabriqués grâce à une gravure de 10 microns

- 4 bits d’information traités à chaque cycle

- 740 kHz de fréquence d’horloge

L’Intel 4004 marque le véritable coup d’envoi d’une ère nouvelle. Son architecture ouvre la voie à une industrie en plein éveil et place l’entreprise américaine au centre de la vague micro-informatique qui s’annonçait.

Pourquoi ce pionnier a bouleversé l’histoire de la technologie

L’Intel 4004 n’est pas qu’une belle prouesse. Sa sortie balaye d’un revers les méthodes d’assemblage antérieures. Jadis, il fallait connecter une infinité de circuits dédiés à chaque fonction. Désormais, tout s’imbrique dans une seule puce : la miniaturisation se généralise, l’informatique s’émancipe des laboratoires et s’approche, peu à peu, du grand public.

L’arrivée du microprocesseur change la donne. Après le 4004, d’autres modèles surgissent, porteurs de nouvelles ambitions. Les 8008, puis 8088, redessinent le marché : applications embarquées, premiers ordinateurs facilement transportables, appareils ménagers ou industriels. Le microprocesseur devient le socle de toutes les architectures ultérieures. La route est ouverte vers les processeurs multicoeurs, les architectures ARM et les géants du cloud d’aujourd’hui.

L’impact se ressent très vite. Les prix chutent, l’accès à l’informatique s’étend dans l’enseignement, les entreprises et peu après chez les particuliers. Les années 1970 voient apparaître les premiers micro-ordinateurs, les systèmes d’exploitation qui feront référence, et l’entrée de l’informatique dans les foyers. De la puce 4004 aux processeurs récents capables de faire tourner une intelligence artificielle ou un centre de données, le fil conducteur ne s’est jamais rompu. Toute l’économie numérique actuelle trouve là ses racines, dans cette révolution technologique loin d’être conventionnelle.

Des anecdotes étonnantes sur les débuts du microprocesseur

En remontant aux débuts du microprocesseur, on découvre quantité d’histoires surprenantes qui tranchent avec le récit institutionnel bien rôdé. À l’origine, l’Intel 4004 voit le jour grâce à la demande d’une société japonaise de calculatrices, Busicom, qui souhaitait douze circuits distincts pour ses appareils. Ted Hoff ose un concept radicalement différent : plutôt que de développer douze composants séparés, pourquoi ne pas tout rassembler sur une seule puce ? Pari osé, mais accepté. La miniaturisation connaît alors une vraie accélération.

Federico Faggin rejoint l’aventure et met au point des techniques industrielles inédites pour concevoir les premiers circuits intégrés de ce type. Dans les laboratoires, les essais se font parfois avec des instruments improvisés, ajustés sur-le-champ, dans une ambiance où l’urgence et l’expérimentation priment sur la théorie. Pour vérifier la robustesse du 4004, l’équipe va jusqu’à créer un jeu de morpion entièrement automatisé, tenu par la puce, sourire complice à la prémisse de l’intelligence artificielle embarquée.

Le 4004 plafonne à 740 kHz, une cadence qui, aujourd’hui, fait sourire. Pourtant, l’ingéniosité des concepteurs ne cesse d’impressionner : à partir de là, des calculatrices portatives deviennent réalité, tout comme les premiers contrôleurs industriels. L’époque ignore encore tout des outils informatiques modernes. Les pionniers avancent à l’intuition, font, défont, recommencent jusqu’à trouver la bonne formule. Cette méthode “artisanale” jette pourtant les bases des architectures qui propulsent désormais smartphones et datacenters, et dirige l’évolution de la puissance numérique actuelle.

Un simple rectangle de silicium, quelques milliers de transistors, et la technologie a soudain changé de cap, pour ne plus jamais revenir en arrière.